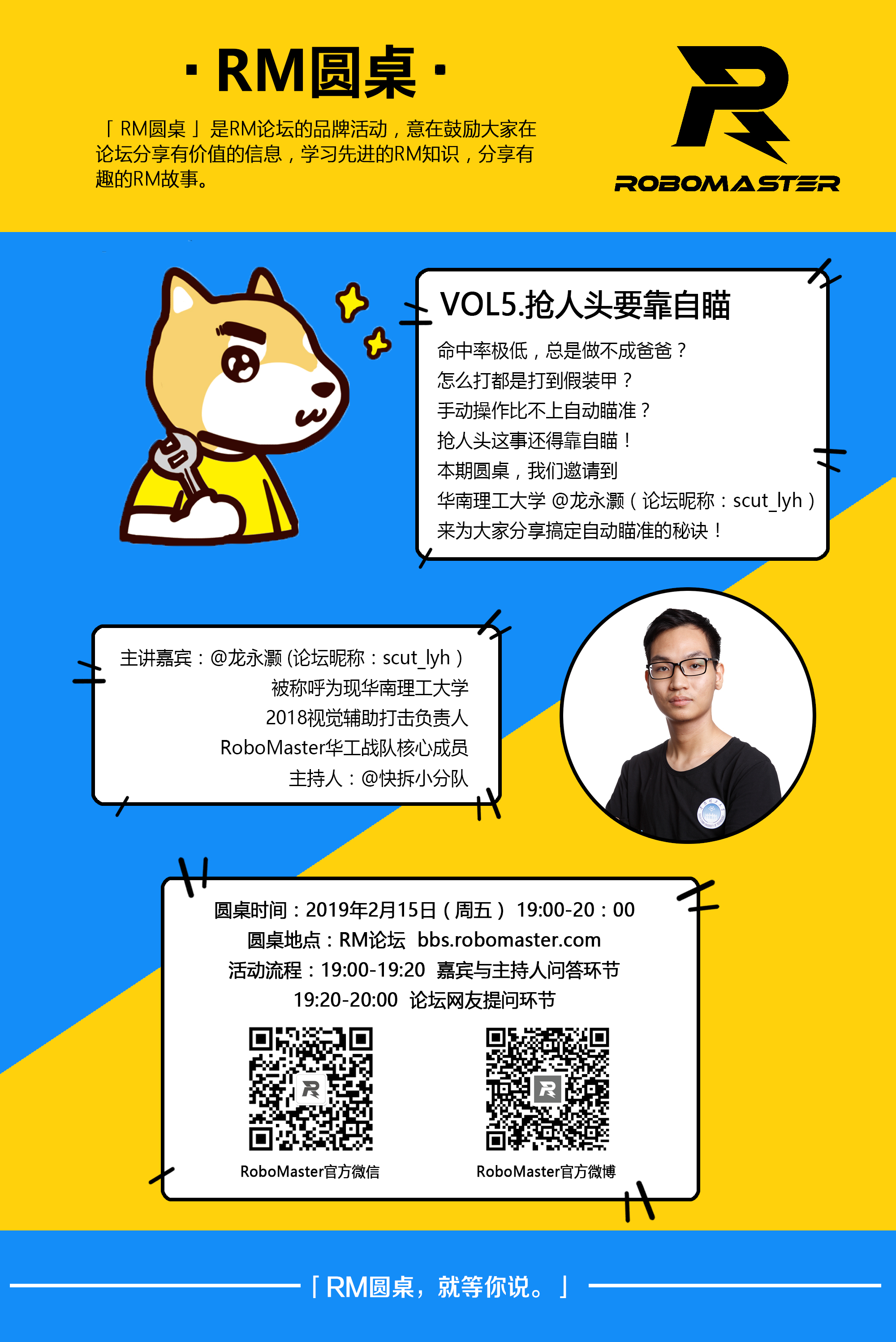

「2019」「RM圆桌」第五期 抢人头要靠自瞄

19468

0

217

2019-02-14

圆桌时间:2019年2月15日(周五) 19:00-20:00

圆桌嘉宾:@龙永灏(论坛昵称:scut_lyh)

温馨提示:

在直播期间,大家可以直接移步至论坛技术交流版块,直播墙会自动实时更新内容。

在前20分钟内,为主持人嘉宾对话时间,这段时间内嘉宾是不会回答其他参与者的问题的,大家可以在后面40分钟的自由问答时间内提问。

参与本期活动的网友,我们将挑选出一位优秀提问者,奖励3510电机(8成新)。

==================================================================

1、 什么是自瞄?你们是怎么利用自瞄获取比赛胜利的?为什么要做自瞄?优势在哪?

所谓自瞄,就是利用机器视觉来实现自动瞄准敌方和辅助打击的一种技术,在以往的比赛中,都是以纯手动打击为主,但人的操作和反应能力往往不如机器的快,正确的使用自瞄,宛如“开挂”一般,可以大大提升各单位的命中率既输出能力,给己方的输出提供强有力的支持和保障,在赛场上,拥有自瞄的队伍通常能起到非常强大的震慑作用,给队伍带来很大的技术优势。

2、 自瞄怎么做起?

1)编程语言选择

C++、python:

C++是编译型语言,是编译执行的,程序是先需要编译成二进制执行程序,既机器码,然后才能执行,编译的时候编译器可以进行一些优化,python是解释型语言,是解释执行的,和物理机CPU之间多了解释器这层,所以运行效率C++ >> python。

但python也有它的好处,python编程更加简单高效,不需要像C++一样要去关心底层内存的操作,python使程序员只需更加关注程序的目标而不是过程,所以非常容易上手,也非常容易实现想要的功能。

通常最好的选择是用c++搭建辅助打击框架,不过python也可以用在部分算法的验证、辅助工具的编写上面,在编程能力有限的情况下,python也是个不二选择。

2)第三方库的运用

俗话说的好,前人栽树后人乘凉,如果所有的算法都从零写起那得需要多少时间和经历,是十分不可取的,所以合理使用第三方平台能快速实现想要的功能。

OpenCV:OpenCV是一个基于BSD许可(开源)发行的跨平台计算机视觉库,可以运行在Linux、Windows、Android和Mac OS操作系统上。它轻量级而且高效——由一系列 C 函数和少量 C++ 类构成,同时提供了Python、Ruby、MATLAB等语言的接口,实现了图像处理和计算机视觉方面的很多通用算法。

OpenCV的官网有很多教程,同时社区也很完善,很多问题直接搜索就可以解决:https://opencv.org/

HALCON:HALCON是德国MVtec公司开发的一套完善的标准的机器视觉算法包,拥有应用广泛的机器视觉集成开发环境。它节约了产品成本,缩短了软件开发周期——HALCON灵活的架构便于机器视觉和图像分析应用的快速开发。

HALCON学习网:http://www.ihalcon.com/(包含教程、软件下载、论坛等)

普遍的方案都是使用C++和OpenCV实现视觉算法,而HALCON是商业级别的软件(说白了就是正版要用钱买,而且比较贵),由于其使用的简易性、调试的便捷性和算法的高度集成性,在工业上采用的极多,HALCON可以通过可视化编程和利用一系列辅助工具缩短程序开发时间,同时该平台提供了大量实际应用的成熟方案DEMO,例如OCR光学字符识别、零件尺寸测量、三维物体识别等等,其运行效率和精度也是不容小觑的。

3)计算平台的选择

这里介绍两种主流的选择

A、NUC

NUC是intel推出的mini PC,性能和日常使用的笔记本甚至台式机的性能相当,优点是体积较小,而且由于是intel框架的,程序的移植非常容易,不需要做什么修改就能从自己的PC移植到NUC上,缺点是显卡用到是Intel的集成显卡,不易使用GPU加速的算法。

[attach]21664[/attach]

NUC的图片

B、NVIDIA JETSON(TX1、TX2)

NVIDIA Jetson 是业内领先的 AI 计算平台,它面向移动嵌入式系统市场中的 GPU 加速并行处理。在深度学习和计算机视觉方面的高性能、低能耗计算,使得 Jetson 成为计算密集型嵌入式项目的理想平台。

因为该平台和PC的框架不同,所以使用过的人都会发现该平台有些很奇怪的坑,但如果用好了,该平台的性能是远大于NUC的,尤其是它在神经网络上的加速,是NUC无法比的,此外,TX1、TX2的体积和质量比NUC小很多,非常适合在对重量敏感的机器人上应用(如无人机)。

[attach]21665[/attach]

TX2核心板的图片

当然以上两个计算平台的共同特点就是贵……..

如果想要节省RMB,就只能牺牲计算的速度,退而求其次选择其他的开发平台,

例如Firefly的ARM开发板,官网传送:http://www.t-firefly.com/

3、 自瞄算法的一般思路

1) 设置合适的相机帧率和曝光时间:在自瞄的应用下,较高帧率和较低的曝光时间对图像处理有很大的帮助,可以避免过多噪声,防止运动过快导致图像模糊,这些参数需要在不同光照条件下进行测试调参。

2)图像预处理

因为灯条分为红蓝两色,预处理时可以采取颜色分割的方法将图像处理为二值图方便下一步的灯条提取。

HSV颜色空间分割:通常相机获取得到的图像都是RGB颜色空间,不方便直接进行颜色分离,因此转化为HSV颜色空间再进行分割。

HSV颜色空间由色调(Hue)、饱和度(Saturation)、亮度(Value)三个分量构成,HSV更接近于人眼的主观感受。我们可以通过下面的图来展示HSV颜色分布情况:

[attach]21667[/attach][attach]21668[/attach]

通过寻找红色蓝色对应的分量,将该颜色的区域划分出来,最后得到二值化的图像。

[attach]21669[/attach]

3)灯条提取

首先将上面处理好的二值图的轮廓提取出来(例如使用opencv的findContours函数),然后通过一系列条件排除掉假灯条,接着用最小包围矩形或最小包围椭圆去计算各个轮廓,选出最符合灯条特征的轮廓(例如判断灯条的长宽比、形状等等)。

4)装甲片识别

提取出所有可能的灯条之后,将“灯条”两两匹配,根据两“灯条”之间的距离、斜率之差、两灯条之间的长度之比等条件选出合适的待选装甲片,之后再通过筛选装甲片选择“最像”的那个(比如通过识别装甲片中间的数字判断是否为真装甲片),计算出装甲片的中点位置,至此完成了装甲片的识别。

5)云台控制

获得装甲片中点位置后,计算该点与图像中心(假设装甲片中心到达图像中心时云台正好对准装甲片中心)的差值,将图像x轴的差值作为云台yaw轴的控制输入量,y轴的差值作为云台pitch轴的控制输入量,不断地发送实时的“偏差”值,做一个闭环的控制。至此就实现了自瞄最基本的功能。

4、 自瞄大家都有做,怎样才能做得稳呢?(做自瞄有什么诀窍?)

1)硬件的选型很重要,有个好的相机可以解决很多算法上的问题,并使算法效益最大化

相机通常有以下一些参数

a.曝光方式(Exposure):全局快门/卷帘快门

b.分辨率(Resolution)

c.最大帧率(Frame Rate)

d.快门速度(Shutter)

e.接口类型:usb2.0/usb3.0/GigE/CSI等

f. 光谱响应特性(Spectral Range):是指该像元传感器对不同光波的敏感特性

….等等

·工业相机与普通相机的部分区别

1. 工业相机的性能稳定可靠,普通相机轻便小巧,易于安装;

2. 工业相机的快门时间短,可以抓拍高速运动物体;

3. 工业相机的帧率通常远远高于普通相机;

4. 工业相机(Industrial Camera)相对普通相机(DSC,Digital Security Control)来说价格较贵。

根据实际需求,选择一个合适的相机对结果非常重要。

2)专注于一点并做到极致,比哪里都做一点的效果更好

例如:大部分学校的自瞄都会出现“跟不上”既云台瞄准跟不上目标的移动,这里提供一个idea,与其想各种各样的预测算法,不如先把现有代码优化到极致,使它的实时性最高并最小化误识别率,最终效果可能会让你意料之外的好。

3)巧妙运用GPU加速

Opencv包含了CUDA(CUDA™是一种由NVIDIA推出的通用并行计算架构,该架构使GPU能够解决复杂的计算问题)加速的版本,有些图像的操作在GPU上的速度会大大提高,而TX2、TX1这类嵌入式平台,往往CPU的处理能力有限,如果所有算法都在CPU上跑效率会大打折扣,而TX2、TX1恰巧完美支持CUDA和提供各种图像加速的API。

5、 自瞄要在备赛的哪个阶段去做呢?你认为达成什么条件做自瞄才能发挥它的用处?

自瞄应该越早做越好,因为自瞄需要充分的鲁棒性测试和命中率测试,需要在不同的环境下测试可行性,测试最终效果是否真的比“手打”好,同时所说的“自瞄”大多数是有人的参与的,既不完全是全自动的瞄准+打击,通常的方案是人为控制是否开启自动瞄准,并且当多目标出现时人为选择要瞄准的目标,手动控制子弹的发射,因此操作手需要对该系统充分熟悉,只有达到人机合一的境界,自瞄才能充分发挥它的效果。

6、 做自瞄最应该避免犯的错误是什么呢?

忽略电控部分的重要性:在视觉识别稳定的情况下,一个优良的控制算法会对效果大大加分,再例如利用响应更快的电机、为自瞄定制的电调,会明显提高自瞄的实时性和命中率。

友情链接:卡尔曼滤波器及其在云台控制中的应用 - 陈健的文章 - 知乎

这篇文章讲述的方法就很好地在电控上做了建模和优化。

7、如果是用神经网络和机器学习去做跟踪处理 现在已经做到可以识别车了那接下来是不是应该转化为识别灯条上的装甲板 华工是在tx2上面进行运算的吗?

答:我们用的都是传统算法识别装甲片的,神经网络的方法没有尝试过,觉得会比较慢;我们在大部分机器人上用的是nuc,无人机上用的是TX2。

答:我们用的都是传统算法识别装甲片的,神经网络的方法没有尝试过,觉得会比较慢;我们在大部分机器人上用的是nuc,无人机上用的是TX2。

8、 请问自瞄过程中,怎样对目标进行预测,运用到什么策略或算法?

2018年的比赛中并没有在预测上做太大的功夫,不过可以尝试一下卡尔曼预测。

9、请问华工现在采用的是什么视觉方案呢?

参考上面回答的一般思路。

参考上面回答的一般思路。

10、视觉算法设计到大量像素运算,为了保证实时性同时不牺牲性能,都有哪些优化方案?

如果用的平台是TX1、TX2的话,可以试试GPU加速

如果用的平台是TX1、TX2的话,可以试试GPU加速

11、请问视觉解算出角度后,与电控之间的配合,有什么需要注意的吗?

其实没有需要特别注意的地方,只要保证串口相互通信正常,和电控的控制算法相匹配即可。

其实没有需要特别注意的地方,只要保证串口相互通信正常,和电控的控制算法相匹配即可。

12、请问在自瞄系统中高性能工业相机是否必要,算法效率真的可以发挥高性能工业相机的性能优势吗?

有必要,能,不过个人认为反过来也是对的,高性能工业相机反而能提高算法的效率。

有必要,能,不过个人认为反过来也是对的,高性能工业相机反而能提高算法的效率。

13、深度学习做检测一般可以达到很高的准确率,但是一般比c++ +opencv方案会更耗时,用深度学习做自瞄这个思路靠谱吗?

我会选择更加实时的方案。

我会选择更加实时的方案。

14、请问进行目标跟踪时有哪些算法能有效帮助我们进行实时跟踪呢?

各种滤波算法。

各种滤波算法。

15、工业摄像机 如果选择高帧率 那么就低像素如果高像素 那么就帧率就会下降 请问你们是怎么选择的?

高帧率低像素。

高帧率低像素。

16、想问下主讲人识别出装甲板后采用什么方法测距比较好呢?

利用小孔成像的原理测距。

利用小孔成像的原理测距。

17、 自瞄摄像头的fov多少比较合适?

看实际情况,如果摄像头安装在云台上,可能60°就够了,但如果摄像头安装在地盘上,可能需要广角一点的摄像头防止目标跟丢。

看实际情况,如果摄像头安装在云台上,可能60°就够了,但如果摄像头安装在地盘上,可能需要广角一点的摄像头防止目标跟丢。

18、GPU加速算法具体怎么实现呢?

cuda,TensorRT等等。

cuda,TensorRT等等。

19、同问一下大佬识别出目标后除了重力都需要考虑那些补偿呢?

说实话,我们并没有把重力的因素写在算法里面。

说实话,我们并没有把重力的因素写在算法里面。

20、识别出来之后单目测距有什么算法可以优化吗?

单目测距本来也不是很可靠,所以算出来的距离一般只是作为参考使用的,不会作为准确计算的数值使用。

单目测距本来也不是很可靠,所以算出来的距离一般只是作为参考使用的,不会作为准确计算的数值使用。

21、请问大佬的测距用的深度还是双目呢?

单目。

单目。

22、请问要解算打击角度的时候弹道是怎么预测的呢?因为重力影响装甲在图像中心的时候发射弹丸并不能打中啊。

把准星参考点补偿高一点。

把准星参考点补偿高一点。

23、优先级的判断是要交给操作手吗?

战场的情况很复杂,不能保证算法的决策比人的决策可靠。

战场的情况很复杂,不能保证算法的决策比人的决策可靠。

24、卡尔曼对于爆发运动预测效果还是比较差,请问有什么好的解决方案吗?

自己写相应的滤波算法,将所有可能的情况考虑进去。

自己写相应的滤波算法,将所有可能的情况考虑进去。

25、有性价比高的工业相机推荐吗,或者是比较实用的上?

我们直接在淘宝上选的比较便宜的不知名品牌,不过比较好的牌子可以考虑海康威视、大华。

我们直接在淘宝上选的比较便宜的不知名品牌,不过比较好的牌子可以考虑海康威视、大华。

26、大佬们是怎么解决自瞄算法处理产生延迟,影响云台控制的?

我们的做法是将视觉算法的速度做到极致,来使延迟的影响最小化。

我们的做法是将视觉算法的速度做到极致,来使延迟的影响最小化。

27、请问贵校有在自瞄系统中使用例如KCF跟踪一类的跟踪算法?

并没有使用。

并没有使用。

28、如果要用卡尔曼预测的话,他的Q、R值应该如何整定?

可以参考这篇知乎https://zhuanlan.zhihu.com/p/38745950

可以参考这篇知乎https://zhuanlan.zhihu.com/p/38745950

29、想问一下大佬华工这样的顶级队伍分辨率采用多少呀,帧率能到达多少呢?

用的是640*480,帧率60。

用的是640*480,帧率60。

30、请问贵校使用的摄像头图像采集的延迟有多大?150ms可以接受吗?

这个我们没测过;不过150ms延时可能有些大,移动目标基本很难打中。

这个我们没测过;不过150ms延时可能有些大,移动目标基本很难打中。

31、那NUC是否运用加速算法呢?

NUC没有用GPU加速,都是用CPU跑的。

NUC没有用GPU加速,都是用CPU跑的。

32、请问大佬有没有使用粒子滤波,KCF或者等等其他的跟踪算法吗?

没有,就只是自己写了一些防止数据跳动的滤波算法。

没有,就只是自己写了一些防止数据跳动的滤波算法。

33、请问大佬是用什么机器学习模型算法呢,还是使用深度学习呢?

没有用到机器学习。

没有用到机器学习。

34、请问一下大佬有用yolov3这样的算法吗?

没有。

没有。

35、请问算法单帧耗时大概是个什么情况呢?跟随时又是怎么消除这个延时所带来的影响呢?

单帧大概20ms,我们并没有用上什么算法来消除延时,就只是尽量提高运行帧率,不过可以考虑卡尔曼滤波。

单帧大概20ms,我们并没有用上什么算法来消除延时,就只是尽量提高运行帧率,不过可以考虑卡尔曼滤波。

36、小白提问:请问提升识别的稳定性从哪些方面进行呢?识别时断时续。

将所有可能的情况考虑进去,同时要充分测试各种环境下的识别率。

将所有可能的情况考虑进去,同时要充分测试各种环境下的识别率。

37、请问一下大佬,单目的话,距离信息怎么求解呢?pnp算法吗?

利用小孔成像的原理,pnp也可以求解出。

利用小孔成像的原理,pnp也可以求解出。

38、请问进行目标跟踪时有哪些算法能有效帮助我们进行实时跟踪呢?什么滤波算法比较优秀呢?

还是卡尔曼。

还是卡尔曼。

39、那一般来说,pnp的误差大概是多少呢?

需要实际测试,不同场景、摄像头、算法都有影响,给个参考,10%左右。

需要实际测试,不同场景、摄像头、算法都有影响,给个参考,10%左右。

40、请问华工这些滤波算法是视觉做呢还是电控做呢?

视觉。

视觉。

41、请问工业相机选择帧率多少的比较合适呢?在算法优化到最佳情况的条件下。

60以上。

60以上。

42、想请问一下弹道的预测方面时使用了什么模型呢?实际测试中弹道比较散,请问出了摩擦轮闭环以外还有什么方法可以提高弹道的集中度吗?

我们做的时候没有特地考虑弹道的预测,有关弹道的问题要问机械组的成员,我不太清楚。

我们做的时候没有特地考虑弹道的预测,有关弹道的问题要问机械组的成员,我不太清楚。

43、大佬对DSO算法有什么见解吗?

没用过、也没听说过。

没用过、也没听说过。

44、问大佬,目前opencv的跟踪算法有哪些比较靠谱?

opencv没有提供很多跟踪算法,主要是用来提取特征、识别装甲片。

opencv没有提供很多跟踪算法,主要是用来提取特征、识别装甲片。

45、请问在识别过后是否使用了跟踪算法进行目标跟踪?

没有。

没有。

46、那请问大佬对于视觉识别到的目标信息是怎么处理的呢,是作为云台双环的输入量?还是代替云台位置环?

这个问题我不是很清楚,但输入的是相对量(偏差)。

这个问题我不是很清楚,但输入的是相对量(偏差)。

47、刚才大佬说摄像头安装在云台上60°就够了,又说采用低分辨率高帧率,那这样远处的物体不很小很难识别吗,这样请问下大佬识别多远的物体呢?

的确不是很远,3m的效果是最好的。

的确不是很远,3m的效果是最好的。

48、请问一下除了采用PNP粗测,华工用于精确测距的算法是什么呢?

没用用其他的精确测距算法。

没用用其他的精确测距算法。

49、单目不可靠的话大佬没有考虑其他测距方式吗?

目前没有。

50、请问大佬队伍对于多目标同时出现 是采用操作手手动筛选的还是算法自己选择 我觉得靠操作手去手动筛选的这个程序写不来?

靠操作手。

靠操作手。

51、同mym问,单目的粗测不靠谱只能用与参考,那该用什么数值作为准确计算用呢?

我们直接用粗测的值计算的。

我们直接用粗测的值计算的。

52、小白的视觉算法一换光源就瞎了,总需要临场调试。大佬们的视觉是怎样适应不同光线条件,怎样高效的在比赛条件下调试的?

这个问题问的比较广,总的来说就是调整摄像头的参数,提高算法的鲁棒性,在比赛条件下通过录像后期调试,测试场地时最好能实现远程调试。

这个问题问的比较广,总的来说就是调整摄像头的参数,提高算法的鲁棒性,在比赛条件下通过录像后期调试,测试场地时最好能实现远程调试。

53、想问下大佬用多少分辨率,帧率又能达到多少?

同上。

同上。

54、请问大佬们的整块视觉算法花费的时间是多少呢?

搭出框架2周,剩下的时间主要优化、调试。

搭出框架2周,剩下的时间主要优化、调试。

55、请问您说的高帧率是指多少百帧以上呢?请问发给下位机的频率多少比较适中呢?

高帧率一般60以上够用,当然越高越好,只要算法的速度有那么快,发给下位机的频率要看串口波特率还有电控那边的处理能力。

高帧率一般60以上够用,当然越高越好,只要算法的速度有那么快,发给下位机的频率要看串口波特率还有电控那边的处理能力。

56、请问大佬,识别装甲板,怎么区分大小装甲板呢?因为使用pnp,大小装甲板参数不一样啊。

可以考虑识别装甲片中间的数字。

可以考虑识别装甲片中间的数字。

57、60帧是不是有点保守?

主要看算法的速度,如果你处理一帧下来的时间要20ms,那大于60帧也并不会提升太大效益,当然如果钱多,买到330帧甚至更高的当然好。

主要看算法的速度,如果你处理一帧下来的时间要20ms,那大于60帧也并不会提升太大效益,当然如果钱多,买到330帧甚至更高的当然好。

58、请问大佬60帧不会发生卡顿吗?

参考上一问,没有明显的卡顿。

参考上一问,没有明显的卡顿。

59、很多调好的参数改变光照后就检测不到装甲了,这个问题有解吗?

除了用鲁棒性更高的算法,就只能根据现场光照微调参数了。

除了用鲁棒性更高的算法,就只能根据现场光照微调参数了。

60、请问大佬们是怎么选取最优目标的呢?

操作手选择。

操作手选择。

61、自瞄的时候是完全把云台的控制权交给视觉吗?那这时候底盘的方向是怎么控制的?还是自动跟随云台吗?

是,地盘跟随云台。

是,地盘跟随云台。

62、请问大佬,看了下大佬的回复,我看到的是贵校没有用opencv的如KCF的跟踪算法也没有用到预测算法,贵校的自瞄是以计算装甲板中心与图像中心,并补偿为主嘛?

基本上是

基本上是

63、请问大佬,自瞄是怎么解决误识别问题呢?我在做自瞄,现在,误识别很严重。

还是要将所有情况考虑进去,剔除伪装甲片,同时可以考虑识别装甲片的数字。

还是要将所有情况考虑进去,剔除伪装甲片,同时可以考虑识别装甲片的数字。

64、用于云台上的单目自瞄摄像头可以解决今年大符识别的问题吗?

这里不讨论大符的问题。

这里不讨论大符的问题。

65、请问下大佬,长焦和广角不能兼顾的话,应该重点关注多少米的目标呢?

看需要,如果操作手适合打静距离目标就放在2-3m,如果喜欢狙击的话就用长焦。

看需要,如果操作手适合打静距离目标就放在2-3m,如果喜欢狙击的话就用长焦。

66、看往届视频,很多学校会在底盘上面安装双目摄像头,这个主要是用来做什么的?

其他学校不清楚,我们前年用两个摄像头只是备用。

其他学校不清楚,我们前年用两个摄像头只是备用。

67、没有机器学习怎么识别贴纸和打符呢?

自瞄没用机器学习,打神符才用了。

自瞄没用机器学习,打神符才用了。

68、请问大佬既然说单目测距不准那贵校是如何获取准确的距离信息呢?

同上。

同上。

以下补充,乱入的电科小哥的回答:

视觉算法设计到大量像素运算,为了保证实时性同时不牺牲性能,都有哪些优化方案?

--在自瞄中,如果识别到了目标可以缩小区域而不是进行全局搜索,即采用ROI的方法减少图像的运算,提高算法速度。

--在自瞄中,如果识别到了目标可以缩小区域而不是进行全局搜索,即采用ROI的方法减少图像的运算,提高算法速度。

请问在自瞄系统中高性能工业相机是否必要,算法效率真的可以发挥高性能工业相机的性能优势吗?

--在自瞄系统中工业相机还是有必要的,因为工业相机的帧率会高于普通相机,对于普通相机来说,采集图像所耗的时间接近图像算法处理时间,所以帧率高可以提高整个自瞄的效率。

--在自瞄系统中工业相机还是有必要的,因为工业相机的帧率会高于普通相机,对于普通相机来说,采集图像所耗的时间接近图像算法处理时间,所以帧率高可以提高整个自瞄的效率。

同问一下大佬识别出目标后除了重力都需要考虑那些补偿呢?

--可以考虑空气阻力的影响

--可以考虑空气阻力的影响

请问要解算打击角度的时候弹道是怎么预测的呢,因为重力影响装甲在图像中心的时候发射弹丸并不能打中啊。

--子弹是一个抛物线模型,需要考虑重力的影响

--子弹是一个抛物线模型,需要考虑重力的影响

大佬们是怎么解决自瞄算法处理产生延迟,影响云台控制的?

--算法相对控制的延时是一定存在延迟的,所以要加入预测去补偿延迟。

--算法相对控制的延时是一定存在延迟的,所以要加入预测去补偿延迟。

请问贵校使用的摄像头图像采集的延迟有多大?150ms可以接受吗?

--竞培的小哥哥回答,采集图像延时150ms有点儿高,一般工业相机的帧率有100hz,延时可以控制在10ms左右。但如果是普通相机的话,延时就会比较高。

--竞培的小哥哥回答,采集图像延时150ms有点儿高,一般工业相机的帧率有100hz,延时可以控制在10ms左右。但如果是普通相机的话,延时就会比较高。

还有一些感悟,有同学说大佬的回答有点保守,以下引用@山野个小菜花哟 的话告诉大家

简单的东西做到极致,真的很厉害了呀。很多行成商业应用的内容,本质原理也不难,但是难在可以做到稳定,做到有极高的鲁棒性。做RM不是写学术论文,没必要把东西吹嘘的那么大,简简单单才是真。越简单的东西反而越不容易出错。

关联专栏

RoboMaster 课程沙龙

文章标签

请问这篇文章对你有用吗?

「2019」「RM圆桌」第五期 抢人头要靠自瞄